¿Alguna vez has sentido que tu negocio podría dar un salto enorme con la inteligencia artificial, pero no sabes por dónde empezar a personalizarla? Imagínate tener un asistente que no solo entiende lo que quieres, sino que se adapta a tus necesidades específicas, haciendo que cada interacción sea única y eficaz.

Índice de contenidos

ToggleAquí es donde entran dos enfoques poderosos: Fine-Tuning y RAG (Retrieval-Augmented Generation).

¿Sabes cuál es la diferencia y cuándo conviene usar uno u otro para sacar el máximo provecho de un modelo de lenguaje grande (LLM)?

Conocer esto puede ser la clave para que tu negocio no solo se mantenga competitivo, sino que se distinga con soluciones personalizadas incluso en mercados saturados.

En este artículo, quiero acompañarte para que descubras de manera clara y práctica cuándo y cómo personalizar un LLM para tu empresa.

No importa si eres un experto o estás dando tus primeros pasos en este mundo; aquí te mostraré cómo elegir la estrategia que te dará los mejores resultados y cómo implementarla sin complicaciones.

Prepárate para dar un giro de 360º a la forma en que usas la inteligencia artificial contigo y tu negocio.

Entendiendo las necesidades únicas de tu negocio antes de personalizar un LLM

Antes de lanzarte a personalizar un modelo de lenguaje grande (LLM), es vital que conozcas en profundidad qué es aquello que hace singular a tu negocio. No solo se trata de adaptar tecnología, sino de construir soluciones que realmente potencien tu propuesta de valor.

Esto implica preguntarte: ¿qué tipo de lenguaje utilizan mis clientes? ¿Qué problemas quiero que el LLM solucione puntualmente?

Al responder estas preguntas, estarás definiendo un mapa preciso para no perderte en el vasto universo de opciones de personalización.

En este proceso, te recomiendo que analices distintos aspectos clave que marcarán la dirección de la personalización:

- Sector y especialización: ¿Tu negocio pertenece a un sector altamente técnico, creativo o de atención al cliente? Cada uno requiere una adaptación lingüística y semántica distinta.

- Volumen y tipo de datos: ¿Con qué tipo de información cuentas para entrenar o alimentar al modelo? No es lo mismo manejar textos breves que documentos extensos o bases de conocimiento complejas.

- Interacción esperada: ¿Quieres un LLM que responda preguntas, genere contenido, realice síntesis o ayude en tareas específicas? Identificar la función principal te ayudará a priorizar qué aspectos deben afinarse con precisión.

- Nivel de personalización deseado: ¿Buscas un ajuste profundo del modelo o una integración flexible que se apoye en herramientas externas (como RAG)?

- Restricciones técnicas y recursos: La capacidad técnica, presupuesto y tiempo con los que cuentas también determinarán el alcance real de la personalización.

Con este diagnóstico claro, te aseguras de evitar dos trampas comunes: caer en la personalización superficial que no aporta valor real, o invertir en un proceso tan complejo y costoso que no se ajusta a las necesidades prácticas de tu negocio.

Piensa que, más allá de implementar tecnología avanzada, el objetivo es que el LLM trabaje contigo para mejorar procesos, tomar decisiones basadas en datos y conectar mejor con tu audiencia.

Además, no subestimes la importancia de integrar las expectativas y feedback de tus usuarios finales desde el inicio. Su experiencia puede aportar insights valiosísimos sobre qué aspectos funcionales y lingüísticos deben ser priorizados durante la personalización.

Escuchar a quien realmente utiliza el servicio puede transformar un proyecto tecnológico en una herramienta imprescindible y vivaz para tu negocio.

Finalmente, recuerda que cada emprendimiento es un mundo con matices únicos. La personalización efectiva de un LLM no es solo una cuestión técnica, sino un ejercicio estratégico donde tu visión y objetivos marcan el camino.

Al alinear tecnología y necesidad real, estarás no solo optimizando tu inversión, sino creando un activo digital inteligente que crecerá y se adaptará contigo.

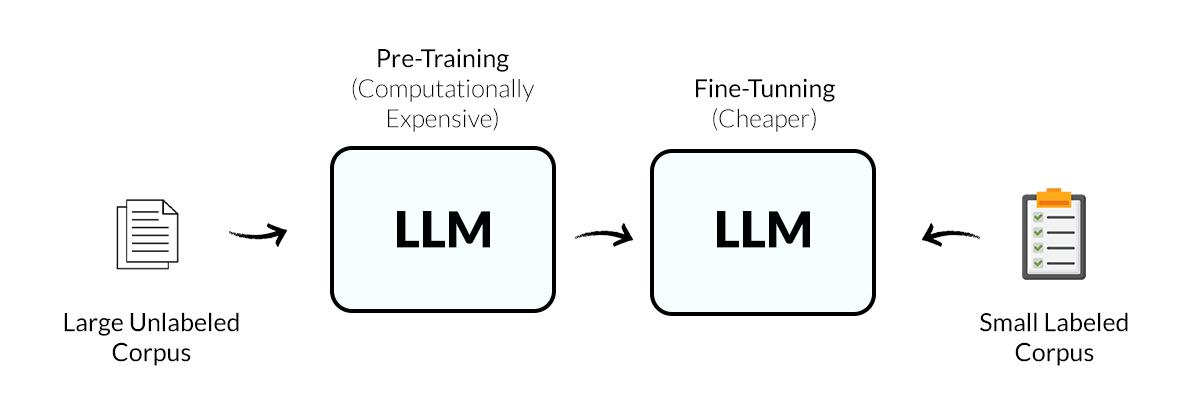

Descubre qué es Fine-Tuning y cuándo es la clave para tus proyectos

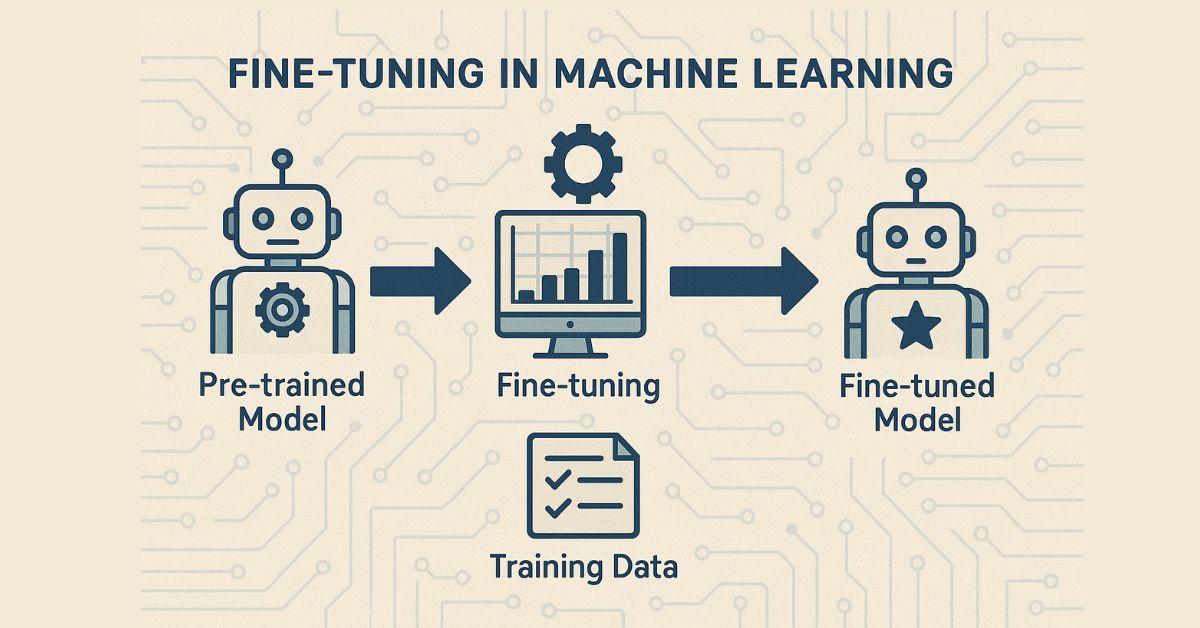

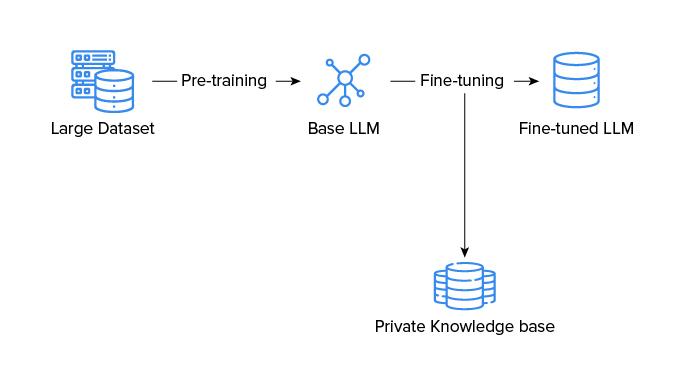

El fine-tuning es esa magia técnica que transforma un modelo de lenguaje preentrenado en un aliado hecho a la medida para tu negocio.

Imagina que tienes un modelo ya poderoso, capaz de entender y generar texto, pero con un pequeño ajuste específico, puede alinearse perfectamente con el tono, el lenguaje y las necesidades concretas de tu empresa.

No se trata de empezar desde cero, sino de realizar ajustes finos y precisos que potencian la efectividad del modelo desde el primer momento, adaptándolo a casos de uso específicos que un modelo genérico no podría manejar con la misma maestría.

Cuando trabajas con fine-tuning, estás personalizando el modelo utilizando un conjunto de datos muy enfocado y relevante para tu industria o producto.

Esto significa que puedes incluir manuales, bases de conocimiento, documentos técnicos o incluso conversaciones previas, para que el modelo aprenda el contexto exacto y responda con mayor precisión y coherencia.

La clave está en que, con estos ajustes menores, consigues un rendimiento superior sin la necesidad de un entrenamiento exhaustivo, lo que se traduce en un ahorro notable de tiempo y recursos técnicos.

¿Cuándo es imprescindible el fine-tuning en tus proyectos? Básicamente, cuando el grado de especificidad y precisión es fundamental para el éxito.

Si necesitas un modelo que no solo comprenda tu sector, sino que también hable el lenguaje de tus clientes, entienda las particularidades de tus servicios y maneje con soltura terminologías propias, el fine-tuning es tu mejor apuesta.

Por ejemplo, en industrias como la salud, finanzas, o legal, donde los errores o generalizaciones pueden ser costosos, esta técnica aporta un valor diferencial palpable.

Además, el fine-tuning es ideal cuando buscas una experiencia de usuario sobresaliente desde el lanzamiento del sistema, ya que esta estrategia permite una mayor precisión desde el inicio.

Si antes tenías que depender de procesos iterativos para corregir fallos de interpretación o relevancia, afinar el modelo garantiza que tus usuarios reciban respuestas que realmente conectan con sus consultas, generando confianza y mejorando la percepción de tu marca.

En definitiva, apostar por el fine-tuning te ofrece varias ventajas contundentes:

- Adaptación específica: el modelo aprende justo lo que tú necesitas, sin desviarse.

- Optimización de recursos: menos tiempo y potencia computacional que un entrenamiento completo.

- Mejora de la precisión: eleva la calidad del output con menor margen de error.

- Mayor control: tú defines qué y cómo se ajusta el modelo.

- Experiencia del usuario: respuestas más naturales y relevantes desde el primer momento.

Si quieres que tu proyecto de inteligencia artificial hable el idioma exacto de tu negocio, entender cuándo es momento de apostar por el fine-tuning es clave para acelerar resultados con eficiencia y precisión.

Explora el poder de RAG y cómo puede transformar la conexión con tus datos

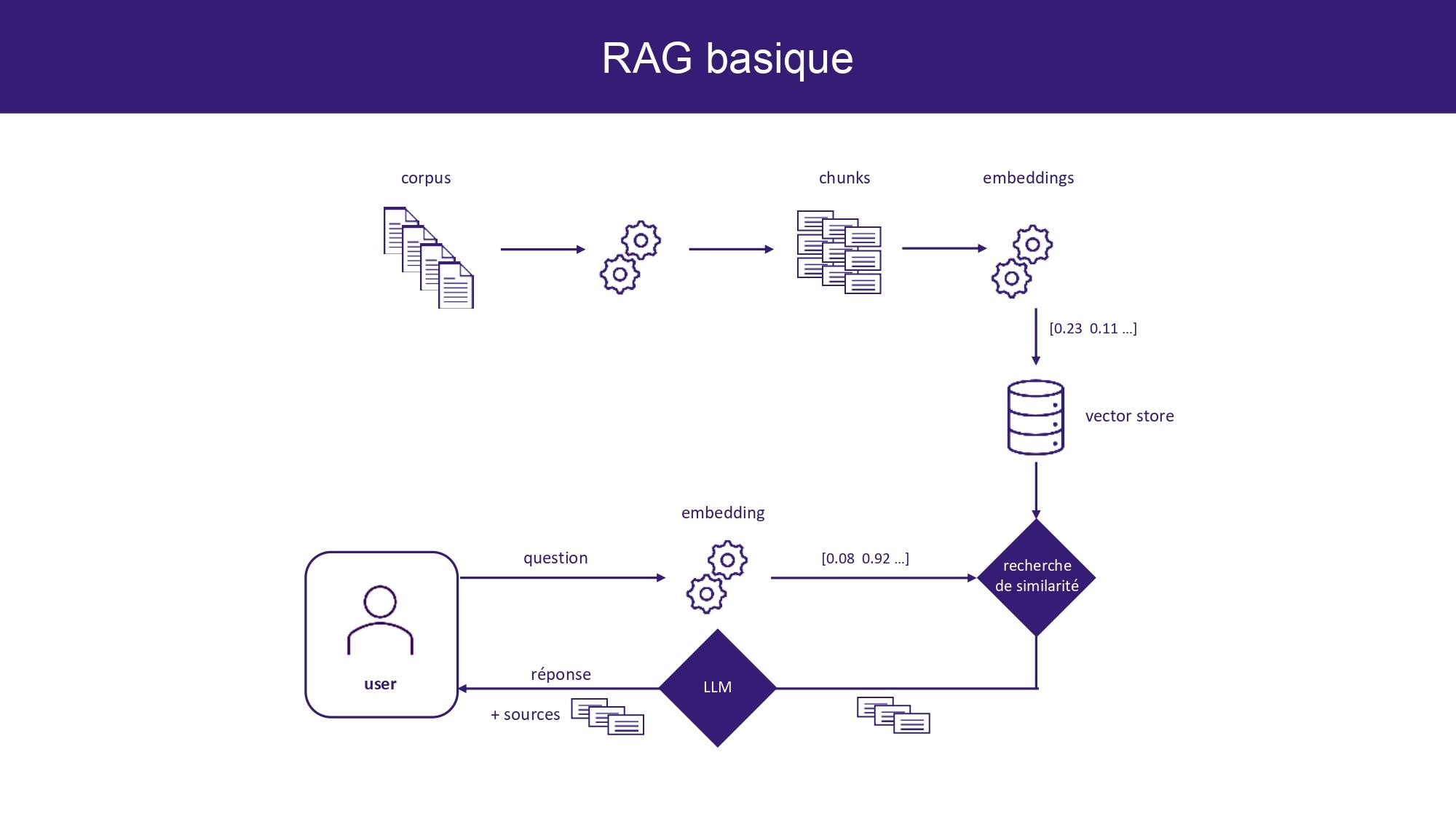

Imagina tener una herramienta inteligente que no solo responde, sino que encuentra en tiempo real la información más relevante para ti y la usa para dar respuestas precisas y actualizadas.

Eso es precisamente lo que hace la generación aumentada de recuperación, o RAG. Esta técnica de inteligencia artificial no se queda atrapada en un conjunto limitado de datos entrenados; en lugar de eso, va a la fuente directa, explorando bases de datos, documentos o incluso la web, para enriquecer cualquier consulta que le plantees con contenidos frescos y específicos.

¿Por qué es tan revolucionario? Porque RAG pone en tus manos un acceso dinámico a tu patrimonio informativo, sin tener que reentrenar un modelo masivo cada vez que cambian tus datos o aparecen nuevas tendencias.

Esto significa que, desde un blog de marketing hasta una plataforma de atención al cliente, puedes ofrecer respuestas que no solo parecen inteligentes, sino que realmente se basan en el conocimiento más actual y exacto que posees.

En la práctica, RAG funciona como un experto que primero consulta tu biblioteca personal antes de hablar contigo, asegurando que cada respuesta esté perfectamente alineada con la información que tienes almacenada.

Para sacarle el máximo partido, solo necesitas:

- Un repositorio bien organizado y accesible, para que RAG pueda buscar sin obstáculos.

- Clareza en tus fuentes de datos, ya sean documentos internos, bases de datos o recursos externos en línea.

- Una integración fluida con tus modelos de lenguaje, para combinar la recuperación de información con la generación de texto.

Adaptar RAG a tu negocio no solo es cuestión de tecnología, sino una estrategia para humanizar y personalizar tus interacciones digitales.

Imagina a un asistente que responde con conocimiento actualizado y específico, que entiende tus productos, servicios y hasta contexto de usuarios, porque consulta directamente tus activos de información. Esto es un paso más allá del simple fine-tuning y él te ofrece un camino para mantenerte relevante sin complicaciones de reentrenamiento constante.

Finalmente, si buscas transformar la forma en que tu empresa conecta con sus datos, RAG es tu aliado para dar respuestas que realmente impacten y cautiven.

No se trata solo de tener inteligencia artificial; es aprovechar esa inteligencia para transformar datos en valor tangible, ofreciendo a tus clientes y equipos acceso inmediato a respuestas inteligentes, fiables y adaptadas a sus necesidades.

Con RAG, la conversación sobre datos gana profundidad, rapidez y precisión, poniendo en tus manos una ventaja competitiva que hoy pocos dominan.

Claves para elegir entre Fine-Tuning y RAG según tus objetivos y recursos

Cuando te planteas personalizar un modelo de lenguaje grande (LLM) para tu negocio, entender las diferencias esenciales entre Fine-Tuning y RAG (Retrieval-Augmented Generation) es clave para optimizar tanto tus resultados como la inversión en tecnología.

Aquí, la elección depende mucho de tus objetivos concretos y los recursos disponibles, porque no todas las soluciones encajan igual en cada proyecto.

Si buscas precisión quirúrgica y un modelo que “hable” con tu propio lenguaje y contexto interno, el Fine-Tuning es una opción que merece atención. Este enfoque implica reentrenar parte del modelo con tus datos específicos, lo que te permite afinar detalles como el tono, vocabulario y conocimiento sectorial. E

so sí, requiere una base técnica sólida, buen volumen de datos bien curados y recursos computacionales considerables, especialmente si buscas un ajuste fino granular (fine-grained). Sin embargo, con ello consigues un modelo que entiende mucho mejor las sutilezas de tu negocio y cliente.

Por otro lado, RAG brilla cuando tu prioridad es rapidez, flexibilidad y economía. La magia del RAG está en complementar el modelo con sistemas de recuperación de información actualizada o especializada en tiempo real, sin necesidad de modificar la arquitectura base.

Esto es ideal para negocios que manejan bases de datos voluminosas o conocimiento cambiante, ya que el modelo puede “consultar” fuentes externas para mejorar sus respuestas. También es mucho más accesible para quienes no cuentan con grandes infraestructuras ni equipos técnicos dedicados al entrenamiento.

Para ayudarte a decidir, valora estos aspectos clave:

- Volumen y calidad de tus datos: Fine-Tuning necesita un dataset robusto y representativo, mientras que RAG funciona bien con índices y buscadores configurados correctamente.

- Capacidad técnica: Fine-Tuning demanda experiencia en machine learning y hardware potente; RAG es más plug-and-play, ideal para equipos con menos experiencia.

- Necesidad de actualización continua: Si tu conocimiento cambia rápido, RAG permite incorporar novedades sin reentrenar el modelo.

- Presupuesto y tiempos: El ajuste fino es más costoso y lento, mientras que RAG puede implementarse y escalarse de forma más económica y ágil.

Finalmente, imagina tu estrategia combinando lo mejor de ambos mundos: puedes empezar con RAG para validar casos de uso y luego, a medida que tus datos y experiencia crecen, dar el salto a un Fine-Tuning más específico.

Así, conviertes la personalización en un proceso escalable y adaptado a tus prioridades, evitando inversiones innecesarias y maximizando el impacto de la inteligencia artificial en tu negocio.

Pasos prácticos para implementar Fine-Tuning sin complicaciones

El fine-tuning de un modelo de lenguaje grande (LLM) puede parecer una tarea titánica, pero con el enfoque correcto, tú también puedes lograr una personalización efectiva y sin complicaciones.

Lo primero que debes hacer es reunir un conjunto de datos representativo y bien estructurado que refleje los matices de tu negocio. Cuanto más específico y limpio sea este dataset, mejor se adaptará el modelo a tus necesidades concretas, evitando escenarios comunes como respuestas genéricas o fuera de contexto.

Una vez que tengas esos datos listos, la clave está en usar herramientas robustas pero accesibles que te permitan realizar el fine-tuning sin tener que reinventar la rueda.

Muchas plataformas actuales te ofrecen pipelines optimizados para entrenamiento rápido y eficiente, con soporte para diferentes niveles de granularidad en el ajuste, desde un tweaking muy ligero hasta una reentrenamiento más profundo.

Este paso es crucial para maximizar la efectividad de la personalización sin complicarte con configuraciones técnicas complejas.

Te recomiendo que enfoques tu proceso de fine-tuning en etapas bien definidas, empezando por un ajuste inicial con un conjunto pequeño de datos para validar que el modelo responde correctamente a tus inputs clave.

Luego, gradualmente, amplía la cantidad y diversidad de ejemplos para que el modelo vaya aprendiendo comportamientos más finos y específicos.

Además, ten presente que monitorear métricas como la precisión, cobertura y coherencia durante el entrenamiento te ayudará a detener el proceso en el punto óptimo, evitando tanto el sobreajuste como el subentrenamiento.

Por otro lado, integrar el fine-tuning con mecanismos de feedback continuo puede ser un as bajo la manga. Habilita canales donde los usuarios puedan reportar errores o proponer mejoras en tiempo real, y utiliza esta retroalimentación para refinar periódicamente el modelo.

Así, logras un ciclo virtuoso donde la personalización no es un evento único, sino un proceso vivo que se adapta contigo y con la evolución de tu negocio.

Finalmente, no olvides que el fine-tuning no es el único camino para personalizar un LLM, pero sí uno muy poderoso cuando buscas que el modelo adopte la voz, el tono y la especialización exacta que necesitas.

Si en algún momento sientes que es demasiado técnico, considera apoyarte en frameworks que automatizan buena parte del proceso o incluso en consultorías especializadas que hagan el trabajo pesado mientras tú te concentras en lo estratégico.

Con la mentalidad y herramientas adecuadas, dar personalización de calidad a tu IA está mucho más al alcance de lo que imaginas.

Cómo integrar RAG para potenciar la inteligencia de tu LLM sin entrenamientos pesados

Integrar Retrieval-Augmented Generation (RAG) en tu modelo de lenguaje es una forma revolucionaria de darle un plus de inteligencia sin la necesidad de embarcarte en procesos de fine-tuning complejos y costosos.

Lo que hace RAG es combinar un sistema de recuperación de documentos con la capacidad generativa de un LLM, ofreciéndote respuestas frescas y precisas basadas en información actualizada y específica del dominio que te interesa.

Así, no tienes que reentrenar tu modelo cada vez que quieras ampliar su conocimiento, sino que el mismo va a buscar y considerar datos externos que complementan su base preexistente.

Para integrar RAG en tu flujo de trabajo, debes primero construir o contar con un repositorio documentado que funcione como la fuente confiable de información.

Este paso es crucial porque toda la magia ocurre cuando el modelo “consulta” este repositorio para enriquecer sus respuestas. El sistema de recuperación interno escanea documentos relevantes y luego el generador procesa esos datos para entregarte una respuesta coherente y personalizada.

Te recomiendo que organices tus fuentes en un índice eficiente para asegurar rapidez y precisión al momento de la consulta.

Las ventajas prácticas de adoptar RAG en lugar de un fine-tuning tradicional se reflejan también en la rapidez de implementación y en la reducción de costos. Al no modificar los parámetros internos del modelo, evitas largos tiempos de entrenamiento y consumos elevados de energía computacional.

Además, puedes actualizar tu base documental en cualquier momento sin depender de reiniciar el entrenamiento, lo cual es ideal para negocios que necesitan adaptarse rápido a cambios en la industria o nuevas tendencias.

Para que saques el máximo provecho de RAG, aquí te dejo un pequeño listado con pasos clave para que la integración sea exitosa:

- Selecciona y curar fuentes: Define con precisión qué documentos o bases vas a usar para nutrir la respuesta del LLM.

- Implementa un sistema de recuperación eficiente: Algoritmos como BM25 o embeddings vectoriales pueden ayudarte a encontrar instantáneamente los textos más relevantes.

- Conecta el backend con el modelo generativo: Asegúrate de que el modelo pueda acceder y procesar la información recuperada para que las respuestas sean coherentes y precisas.

- Optimiza la experiencia del usuario: Ajusta cómo y cuándo el sistema realiza las consultas para entregar resultados ágiles y evitar demoras.

Finalmente, integrar RAG no es solo una técnica, es una estrategia para mantener tu LLM siempre actualizado con información de calidad y alta relevancia sin sacrificar tiempo ni recursos en entrenamientos pesados.

Gracias a esta aproximación, tú podrás dar a tus clientes respuestas específicas, basadas en datos vivos y contextuales, colocando a tu negocio en la frontera de la innovación tecnológica y la personalización inteligente.

Es un camino perfecto para potenciar la inteligencia de tu LLM y conseguir ventajas competitivas valiosas sin complicarte la vida con ajustes técnicos tediosos.

Qué errores evitar al personalizar un LLM y cómo asegurar resultados efectivos

Cuando empiezas a personalizar un LLM, es muy común caer en la trampa de querer abarcarlo todo sin un plan claro. Uno de los errores más frecuentes es no definir con precisión objetivos específicos y medibles.

Sin una meta concreta, el modelo puede terminar generando respuestas poco alineadas con tus necesidades, además de consumir recursos innecesarios. Por eso, antes de abordar cualquier técnica-ya sea fine-tuning o RAG-, te recomiendo armar un mapa claro de qué problemas quieres resolver y cómo medirás el éxito.

Otro fallo que suele sabotear el proceso es subestimar la calidad y relevancia de los datos que usas para personalizar el modelo. Personalizar con datos dispersos, desactualizados o irrelevantes puede hacer que el LLM aprenda patrones incorrectos o sesgados, generando resultados poco confiables o incluso perjudiciales.

Para evitarlo, cuida que la fuente de información sea precisa, representativa y actual, y que esté alineada con el contexto particular de tu negocio.

Además, no ignores la importancia de una interacción iterativa con el modelo. Un error gravísimo es pensar que el fine-tuning o RAG es un proceso de una sola vez.

Personalizar un LLM es un diálogo constante: necesitas analizar resultados, recopilar feedback, y ajustar tanto los datos como los prompts para refinar la salida. Trabajar sin este ciclo de mejora continua limita la capacidad del modelo para adaptarse y aprender de forma dinámica contigo.

También es crítico evitar la falsa ilusión de que más personalización siempre es mejor. A veces, un exceso de fine-tuning puede hacer que el modelo pierda su generalidad y se sobreajuste a casos muy específicos, dificultando su rendimiento en tareas más amplias o inesperadas. En cambio, la combinación inteligente de técnicas, como complementar fine-tuning con RAG para aprovechar bases de datos actualizadas y contextos específicos, puede llevar a resultados mucho más robustos y versátiles.

Para que la personalización sea realmente efectiva, no olvides implementar buenas prácticas como:

- Controlar el desempeño del modelo a través de métricas claras y pruebas constantes.

- Documentar cada paso del proceso para mantener transparencia y facilitar ajustes futuros.

- Incluir feedback de usuarios reales que ayude a corregir desviaciones y mejorar la experiencia.

- Evaluar el costo-beneficio de cada método según tus recursos y horizontes temporales.

Si evitas estos errores y aplicas estos consejos, tendrás un recorrido ágil y efectivo para personalizar tu LLM, logrando potenciar tu negocio con soluciones inteligentes y adaptadas a tu realidad.

Tu plan de acción para maximizar el rendimiento de tu modelo personalizado

Optimiza tu modelo personalizado con un plan de acción claro y efectivo

Para maximizar el rendimiento de tu modelo personalizado, primero debes tener claro que el éxito radica en un balance preciso entre la calidad de tus datos y la profundidad del ajuste que realices.

No se trata solo de alimentar al modelo con mucha información, sino con datos altamente relevantes, bien estructurados y etiquetados para que pueda aprender patrones con sentido y aplicarlos en tus casos de uso específicos.

Empieza por definir objetivos claros y medir resultados. Establece métricas específicas que reflejen el impacto de tu modelo en el negocio, como precisión, tiempo de respuesta o tasa de error.

Evalúa constantemente y ajusta tus estrategias de fine-tuning o RAG, asegurándote que cada iteración aporte un avance tangible. Puedes aprovechar técnicas de validación cruzada y segmentación de datos para conocer en qué escenarios tu modelo brilla y dónde aún puede mejorar.

Un aspecto clave que pocas veces se menciona es la importancia de entrenar con granularidad adecuada. No todos los problemas requieren ajustar el modelo a nivel macro; a veces, concentrarte en una capa fina (fine-grained) de datos específicos puede marcar la diferencia.

Por eso, combina datasets amplios con pequeños subconjuntos de alta calidad, que reflejen el lenguaje, temas y términos propios de tu nicho o audiencia. Así lograrás que el modelo comprenda mejor el contexto y genere resultados más precisos y naturales.

No olvides implementar un sistema dinámico de actualización y retroalimentación. Los modelos basados en LLMs, especialmente los de arquitectura decoder-only, se benefician enormemente cuando se alimentan periódicamente con información fresca y correcciones de errores detectados en producción.

Este ciclo continuo de aprendizaje ayuda a mantener la relevancia del modelo frente a cambios constantes en el mercado o en el lenguaje utilizado por tus clientes.

Finalmente, aprovecha las ventajas tecnológicas de ambos mundos, fine-tuning y RAG, creando una estrategia híbrida si tu caso lo permite.

- Utiliza el fine-tuning cuando tengas datos propios ricos y bien etiquetados, buscando una personalización profunda.

- Aplica RAG para incorporar conocimiento actualizado y externo, manteniendo flexibilidad ante nuevos temas.

Así, no solamente consultas un modelo estático, sino que cuentas con un asistente que combina memoria interna con fuentes dinámicas, potenciando tus respuestas y optimizando la experiencia usuario cada día.